上周末,我们向您介绍了一个相当有趣的新奇事物,这是一个用于检测描绘虐待儿童的图像的新系统。具体来说,苹果将扫描 iCloud 上存储的所有照片,一旦发现,将向有关当局报告这些情况。尽管该系统在设备内“安全”运行,但该巨头仍然因侵犯隐私而受到批评,受欢迎的举报人爱德华·斯诺登也宣布了这一点。

它可能是 你感兴趣

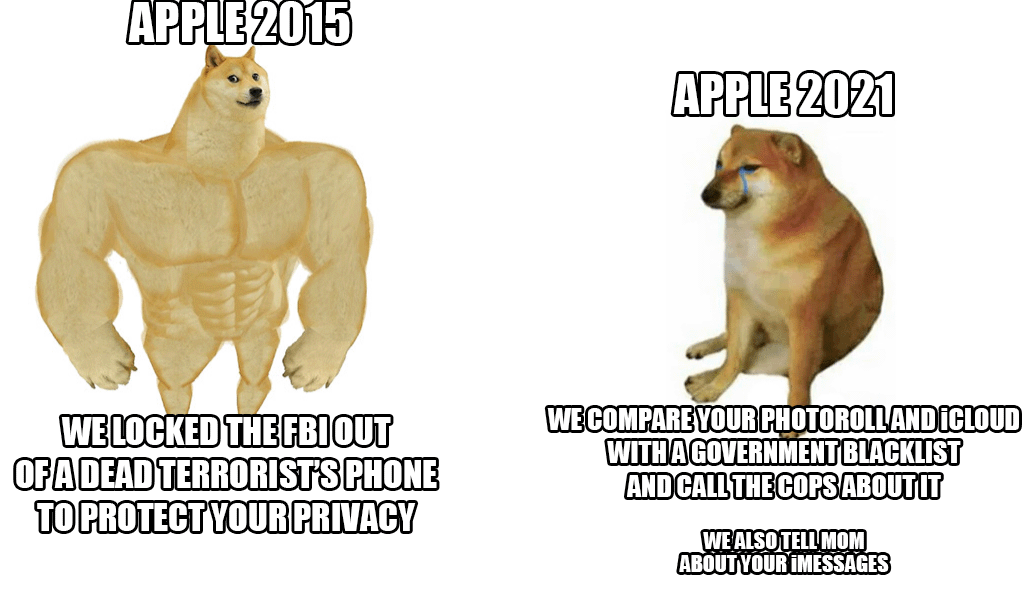

问题在于,苹果到目前为止一直依赖用户的隐私,它希望在任何情况下都保护用户的隐私。但这个消息直接颠覆了他们原本的态度。苹果种植者实际上面临着既成事实,必须在两种选择之间做出选择。他们要么让一个特殊的系统扫描 iCloud 上存储的所有图片,要么他们将停止使用 iCloud 照片。然后整个事情就会变得非常简单。 iPhone 将下载哈希数据库,然后将其与照片进行比较。同时,也会介入新闻,保护孩子,及时告知家长危险行为。然后,人们会担心有人可能滥用数据库本身,甚至更糟糕的是,系统不仅可能扫描照片,还可能扫描消息和所有活动。

当然,苹果必须尽快回应批评。为此,例如,它发布了一份常见问题解答文档,目前已确认该系统仅扫描照片,而不扫描视频。他们还将其描述为比其他科技巨头正在使用的版本更加保护隐私的版本。与此同时,苹果公司更准确地描述了整个事情的实际运作方式。如果将数据库与 iCloud 上的图片进行比较时出现匹配,则会为此事实创建一个加密安全凭证。

正如上面已经提到的,该系统也将相对容易被绕过,苹果直接证实了这一点。在这种情况下,只需禁用 iCloud 上的“照片”即可轻松绕过验证过程。但有一个问题出现了。这值得么?无论如何,好消息仍然是该系统仅在美国实施,至少目前如此。您如何看待这个制度?您是否赞成将其引入欧盟国家,或者这是否过于侵犯隐私?

嗯,这很复杂。隐私保护当然几乎高于一切。这也是我使用这个平台的原因之一。但凡事都有其限度。简而言之,每项自由都以侵犯他人自由而告终。显然,必须对那些愿意伤害或虐待儿童的人采取行动。这是毫无争议的。

正如上面已经提到的,该系统也将相对容易被绕过,这一点得到了苹果的直接证实。在这种情况下,只需禁用 iCloud 上的“照片”即可轻松绕过验证过程。

因为同时表示关闭共享相册。多么简单啊亲爱的华生:)

未经指定机构授权自动翻阅照片原则上是错误的,我敢打赌这只是第一步。有很多事情可以做,一开始是正当的,然后就无法再阻止了:儿童色情->白肉贸易->虐待动物->不注意驾驶->参与反对活动派对...

问题在于是什么使这个过程成为可能。为什么手机和操作系统制造商必须告诉我们作为用户其中包含哪些内容?当然,特别是对合适的孩子来说,听听非常好,因此苹果甚至赞助了一款最先进的设备来处理这个问题。为什么非营利组织要解决这个问题,因为孩子们对国家不感兴趣?如果我没有做错任何事,我并不介意,但他们让每个 iPhone/iPad 用户都成为潜在的犯罪分子。这是扭曲的逻辑,我想说最简单的解决方案之一,我们将安全地扫描您的照片。因此,每个通过 iMessage 向我发送儿童色情内容的人都会感到沮丧,因为我是一个罪犯,我将因我不感兴趣的事情而向一家私人公司负责,同时我不会登录,因为 ID 将被屏蔽。所有那些愚蠢到分享孩子的照片并将其备份到云端的沮丧的人都会去其他地方,因为最愚蠢的人会因此而陷入困境。还有一对父母不小心用pindik/pipinka 给他们的孩子拍了张照片。打的好。

为什么他们会抓那些给他们的孩子拍裸照的父母呢?那样不行

是的,我写错了,所以它可能不起作用。并进一步 ?